Comment installer Ollama pour affiner efficacement les modèles d’apprentissage automatique ?

Ollama est idéal pour exécuter localement et en toute sécurité des modèles de langage de grande taille, assurer la confidentialité des données et réduire les coûts en éliminant les dépendances au cloud. Il est particulièrement utile pour les industries exigeant la confidentialité des données, comme la santé et la finance, tout en prenant en charge la personnalisation pour des cas d’utilisation spécifiques.

Dans cet article, nous expliquons étape par étape le processus d’installation d’Ollama. Vous apprendrez à télécharger le paquet d’installation depuis GitHub, à l’installer sur votre VPS et à effectuer la première configuration pour que tout se passe bien.

En bonus, nous vous montrerons également comment réduire le temps d’installation à quelques secondes avec Hostinger.

Sommaire

Qu’est-ce qu’Ollama ?

Ollama est une plateforme open-source qui vous permet d’exécuter localement de grands modèles de langage (LLM) sur votre machine. Elle prend en charge une variété de LLM populaires, notamment Llama 2, GPT-3.5 et Mistral. En intégrant localement des capacités d’IA dans vos applications, Ollama renforce la sécurité, améliore la confidentialité et permet un meilleur contrôle des performances du modèle.

Avec Ollama, vous pouvez gérer les poids des modèles, les configurations et les ensembles de données par le biais d’une interface conviviale. Il est ainsi plus facile d’adapter les modèles linguistiques à des cas d’utilisation spécifiques. À bien des égards, c’est un rêve devenu réalité pour les développeurs qui aiment expérimenter l’IA.

Mais si vous souhaitez intégrer Ollama dans vos applications web sans dépendre d’API tierces, vous devez d’abord le configurer dans votre environnement d’hébergement.

Conditions préalables à l’installation d’Ollama

Avant de commencer le processus d’installation, vous avez besoin de quelques éléments pour installer Ollama sur votre VPS. Voyons cela maintenant.

Hébergement VPS

Pour faire fonctionner Ollama de manière efficace, vous aurez besoin d’un serveur privé virtuel (VPS) avec au moins 16 Go de RAM, plus de 12 Go d’espace disque, et 4 à 8 cœurs de CPU.

Notez qu’il ne s’agit là que de la configuration matérielle minimale requise. Pour une configuration optimale, vous devez disposer de plus de ressources, en particulier pour les templates comportant davantage de paramètres.

Système d’exploitation

Ollama est conçu pour fonctionner sur des systèmes Linux. Pour obtenir les meilleurs résultats, votre environnement d’hébergement doit fonctionner sous Ubuntu 22.04 ou la dernière version stable de Debian.

Accès et privilèges

Pour installer et configurer Ollama, vous devez avoir accès au terminal ou à l’interface de ligne de commande de votre VPS. Vous devez également disposer d’un accès root ou d’un compte avec les privilèges sudo sous Linux.

Installer Ollama avec un template VPS Hostinger

Maintenant que nous avons couvert les conditions préalables, voyons comment vous pouvez facilement installer Ollama sur votre VPS à l’aide d’un template prédéfini d’Hostinger.

Hostinger a simplifié le processus d’installation d’Ollama en fournissant un template VPS Ubuntu 24.04 préconfiguré pour seulement €5.49/mois.

Il est livré avec Ollama, Llama 3 et Open WebUI déjà installés. Tout ce que vous avez à faire est de sélectionner le template, d’attendre que l’installation automatique se termine, et de vous connecter à votre serveur pour vérifier l’installation.

Voici comment cela fonctionne :

- Connectez-vous à hPanel avec votre compte Hostinger et accédez à VPS → Gérer.

- Dans la barre latérale gauche, allez dans OS & Panel → Système d’exploitation.

- Sélectionnez l’onglet Application et cliquez sur Ollama.

- Cliquez sur Changer le système d’exploitation.

- Attendez la fin de l’installation.

- Connectez-vous à votre VPS en utilisant SSH pour vérifier l’installation.

Et voilà, c’est fait ! Vous devriez maintenant être prêt à utiliser Ollama sur votre VPS Hostinger pour alimenter vos applications web.

Étant donné que le template comporte déjà tous les outils et logiciels requis préinstallés et configurés, vous n’avez rien d’autre à faire avant de commencer à explorer les LLM.

Installer Ollama sur un VPS manuellement

Si vous souhaitez exécuter Ollama sur votre VPS mais que vous utilisez un autre fournisseur d’hébergement, voici comment vous pouvez l’installer manuellement. C’est un processus plus compliqué que l’utilisation d’un template pré-construit, c’est pourquoi nous allons vous guider pas à pas.

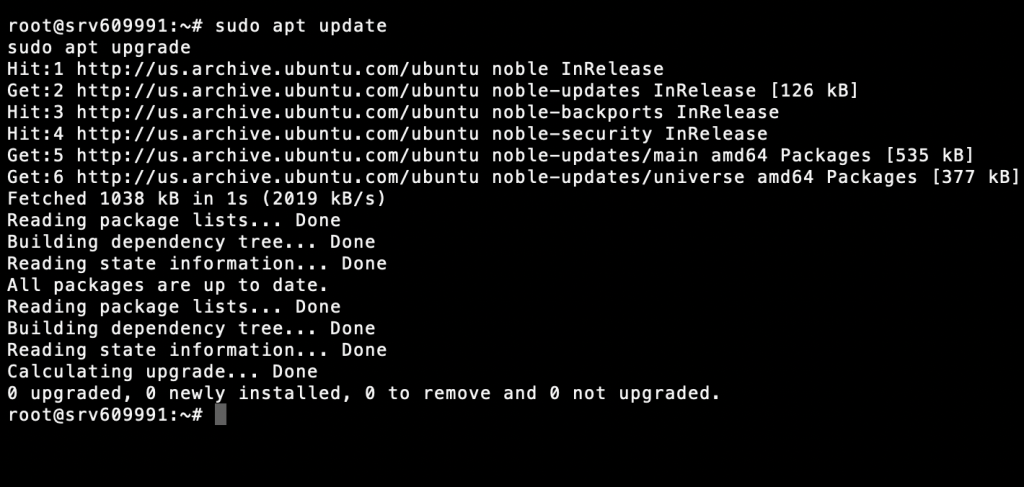

1. Mettre à jour les paquets système

Vous devez vous assurer que votre VPS est à jour avant d’installer un nouveau logiciel. Pour mettre à jour votre liste de paquets et mettre à niveau les paquets d’installation, exécutez les commandes ci-dessous à l’aide de la ligne de commande de votre serveur :

sudo apt update sudo apt upgrade

La mise à jour de votre système permet d’éviter les problèmes de compatibilité et garantit une installation sans heurts du début à la fin.

2. Installer les dépendances nécessaires

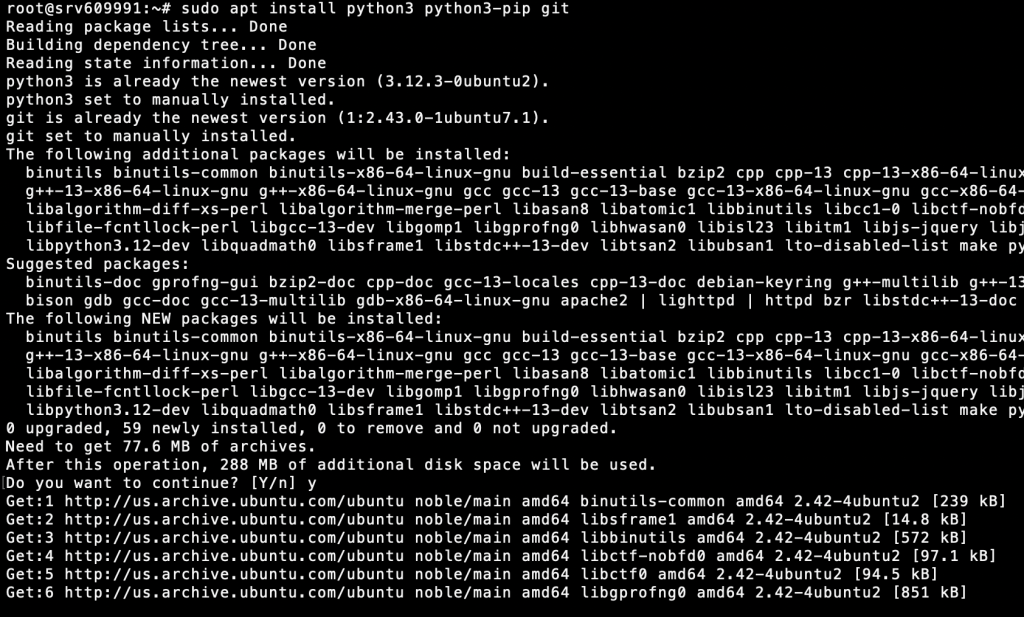

Ollama a besoin de certaines dépendances pour fonctionner correctement. Celles-ci incluent les dernières versions de Python, Pip et Git. Pour les installer, exécutez la commande suivante :

sudo apt install python3 python3-pip git

Vérifiez que l’installation s’est bien déroulée en exécutant le programme :

python3 --version pip3 --version git --version

Si votre VPS est équipé d’un GPU NVIDIA, vous aurez besoin de pilotes CUDA supplémentaires pour profiter des performances accrues du GPU. Ces étapes varient toutefois en fonction de la configuration de votre serveur. Pour en savoir plus, suivez le guide officiel de NVIDIA sur le téléchargement du CUDA Toolkit.

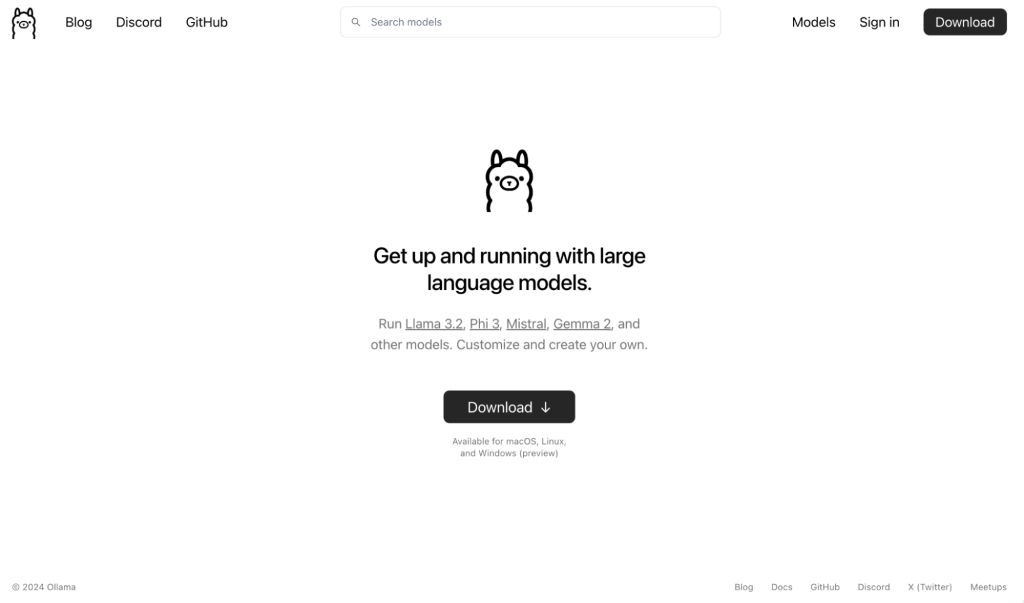

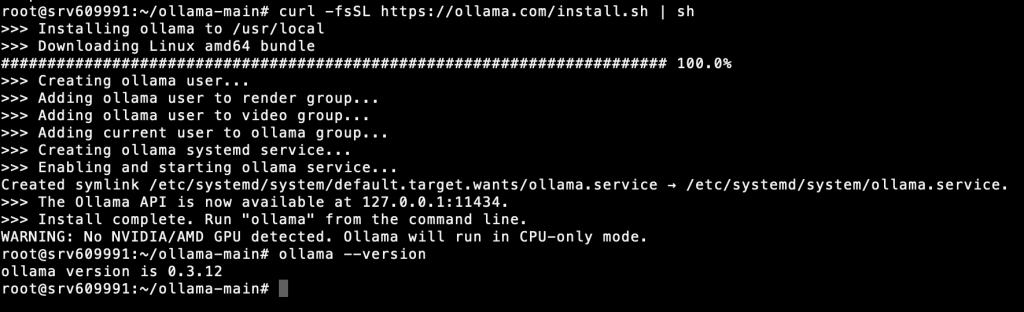

3. Télécharger le paquet d’installation d’Ollama

Ensuite, téléchargez le paquet d’installation d’Ollama pour Linux depuis son site officiel. Vous pouvez le faire en exécutant :

curl -fsSL https://ollama.com/install.sh | sh

Ceci téléchargera et installera Ollama sur votre VPS. Maintenant, vérifiez l’installation en exécutant :

ollama --version

4. Exécuter et configurer Ollama

Maintenant, vous devriez être en mesure de lancer Ollama à tout moment, en utilisant la commande suivante :

ollama --serve

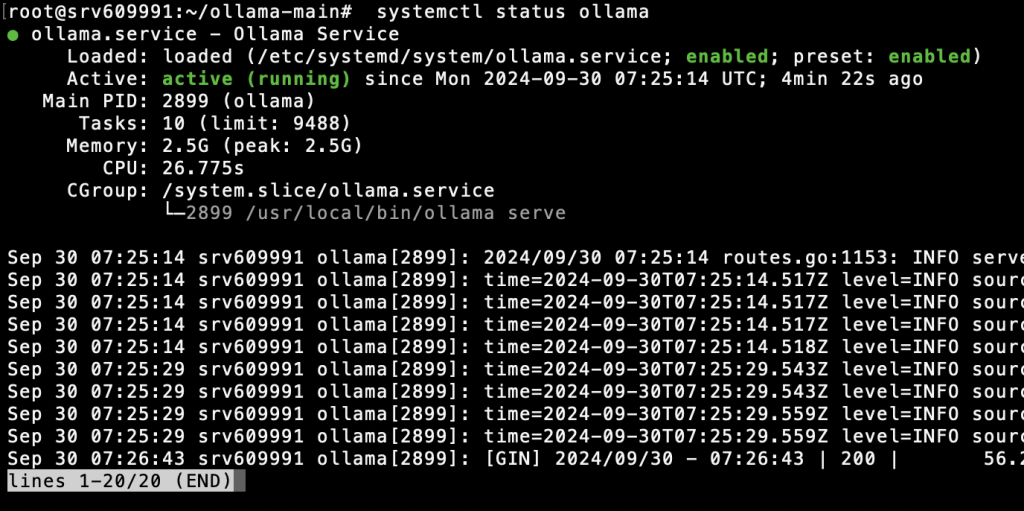

Avant d’aller plus loin, vous devez vérifier l’état actuel du service Ollama en exécutant cette commande dans votre CLI :

systemctl status ollama

Si vous êtes un client Hostinger VPS, vous pouvez également utiliser l’assistant IA Kodee pour confirmer si Ollama est déjà en cours d’exécution sur votre serveur. Depuis votre tableau de bord VPS, ouvrez Kodee via la barre latérale gauche. Ensuite, tapez votre invite comme « Pouvez-vous vérifier si Ollama est en cours d’exécution sur mon serveur ? »

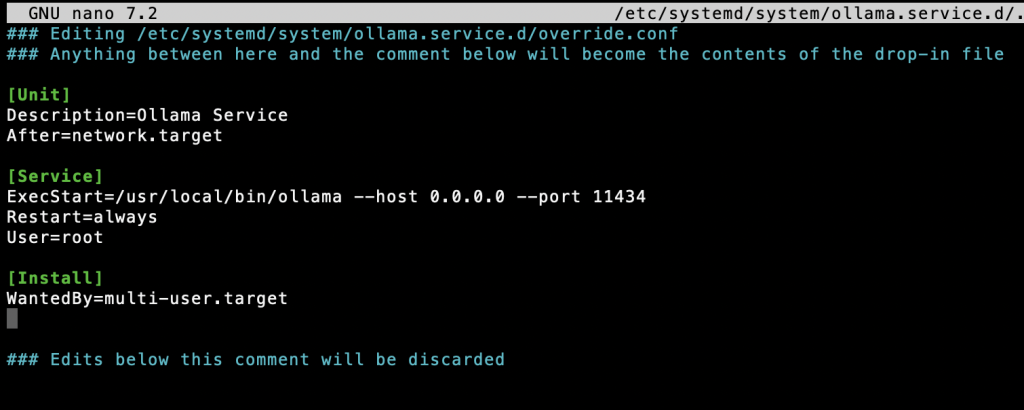

Ensuite, créez un fichier de service systemd pour qu’Ollama s’exécute automatiquement à chaque démarrage de votre VPS :

sudo nano /etc/systemd/system/ollama.service

Ajoutez le contenu suivant à votre fichier de service systemd :

[Unit] Description=Ollama Service After=network.target [Service] ExecStart=/usr/local/bin/ollama --host 0.0.0.0 --port 11434 Restart=always User=root [Install] WantedBy=multi-user.target

Ensuite, utilisez la commande suivante pour recharger l’environnement :

systemctl daemon-reload systemctl restart ollama

Et le tour est joué ! Ollama devrait se lancer automatiquement lors du prochain démarrage de votre VPS.

Note : Bien qu’il offre de nombreuses options de configuration pour modifier le comportement du modèle, ajuster les performances et changer les paramètres du serveur, Ollama est conçu pour fonctionner en utilisant sa configuration par défaut.

Cette configuration fonctionne bien pour la plupart des scénarios, de sorte que vous pouvez commencer tout de suite en récupérant les fichiers de modèle nécessaires. Vous pouvez le faire en lançant “ollama pull <nom_du_modèle>”.

Conclusion

Maintenant que vous avez installé avec succès Ollama sur votre VPS, vous avez accès à une multitude d’outils pour affiner une variété de grands modèles de langage avant de les exécuter localement sur votre serveur. Ollama ouvre un monde de possibilités pour les développeurs, les chercheurs et les passionnés d’IA.

Parmi les cas d’utilisation les plus courants d’Ollama, citons la création de chatbots et d’assistants virtuels personnalisés pour répondre à des besoins spécifiques. Par exemple, vous pouvez créer votre propre assistant de codage pour vous aider dans le développement d’applications web et mobiles, créer un partenaire de brainstorming pour les projets axés sur la conception, ou explorer les possibilités des grands modèles de langage dans la stratégie et la création de contenu.