Comment installer Auto-GPT : Meilleures pratiques et comment l’utiliser en 2025

Le modèle de langage Generative Pre-trained Transformer (GPT) d’OpenAI permet de simplifier diverses tâches, notamment d’aider au développement d’applications telles que GitHub Copilot. Auto-GPT est l’un des nombreux outils utilisant cette technologie.

Auto-GPT est une intelligence artificielle générale (AGI) polyvalente et autonome. Contrairement à ChatGPT, il décompose automatiquement les tâches et fournit des messages de suivi jusqu’à ce que l’objectif soit atteint, avec une intervention humaine minimale.

Pour utiliser cet outil, les utilisateurs doivent le configurer à l’aide de Git et d’une API. Ce tutoriel explique comment installer Auto-GPT sur un serveur privé virtuel (VPS) et partage ses meilleures pratiques.

Sommaire

Qu’est-ce que Auto-GPT ?

Auto-GPT est un agent d’intelligence artificielle polyvalent et autonome basé sur le modèle de langage large GPT d’OpenAI. Contrairement à d’autres modèles d’IA, il peut générer automatiquement des messages de suivi pour accomplir des tâches avec une interaction humaine minimale.

Auto-GPT permet de simplifier diverses tâches, notamment le développement d’applications et l’analyse de données. Pour utiliser l’outil, les utilisateurs doivent cloner le dépôt Git et intégrer l’API OpenAI.

Conditions préalables à l’installation d’Auto-GPT

Vous avez besoin d’un plan d’hébergement VPS pour héberger et exécuter Auto-GPT dans un environnement de production. L’outil ne nécessite pas une grande puissance de calcul, mais votre serveur doit être compatible avec différents logiciels, tels que :

- Python et pip. Le langage de programmation permet à votre système d’exécuter le code Auto-GPT, tandis que le gestionnaire de paquets vous permet d’installer et de gérer les dépendances.

- Git. Ce système de contrôle de version récupère les fichiers et le code de l’Auto-GPT dans le référentiel lors de l’installation.

- Docker. Cet outil compile Auto-GPT avec ses dépendances et ses bibliothèques dans un conteneur, ce qui simplifie le processus de test et de déploiement.

En plus de prendre en charge tous les logiciels nécessaires, le service d’hébergement VPS de Hostinger offre un accès root complet afin d’éviter les problèmes liés aux autorisations lors de l’installation et de la configuration.

Nous fournissons également Kodee, notre outil d’assistant IA, qui aide à générer des commandes Linux, que vous pouvez exécuter sur votre serveur à distance à l’aide de notre terminal de navigateur. De plus, nous proposons des templates pour installer diverses distributions et applications Linux en un seul clic.

Après avoir acheté et configuré un plan VPS chez Hostinger, connectez-vous à l’aide d’un client SSH tel que PuTTY, Terminal ou notre terminal de navigation. Vous trouverez les identifiants de connexion dans l’onglet Accès SSH du menu Aperçu VPS dans hPanel.

Une fois connecté, mettez à jour le gestionnaire de paquets de votre système. La commande diffère selon votre système d’exploitation. Pour Debian, Ubuntu et d’autres dérivés, exécutez :

sudo apt update && sudo apt upgrade

Pour CentOS, AlmaLinux et d’autres dérivés de Red Hat Enterprise Linux (RHEL), utilisez la commande suivante :

sudo yum update && sudo yum upgrade

Important ! Pour déployer Auto-GPT sur Windows, vous pouvez installer le logiciel requis à l’aide de fichiers exécutables ou de l’Invite de commande. Nous recommandons de configurer un éditeur de code comme VSCode pour les ordinateurs locaux afin de pouvoir modifier le fichier facilement.

Comment installer Auto-GPT

Après avoir préparé votre serveur, suivez ces étapes pour installer Auto-GPT sur votre VPS. Comme nous utiliserons Ubuntu 22.04, modifiez les commandes si nécessaire en fonction de votre système d’exploitation.

1. Installer Python et Git

Exécutez la commande suivante pour installer le langage de programmation Python, le gestionnaire de paquets pip, l’environnement virtuel Python et le gestionnaire de dépendances Poetry ::

sudo apt install python3 python3-pip python3-venv python3-poetry

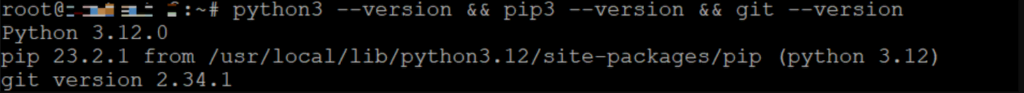

Vérifiez que Python et pip sont correctement configurés sur votre ordinateur à l’aide de cette commande :

python3 --version&

pip3 –-version

Veillez à installer la version 3.8 de Python ou une version ultérieure pour satisfaire aux exigences minimales. Sinon, vous pouvez télécharger le package manuellement à partir de la page des versions de Python.

Installez le système de version Git pour récupérer le dépôt Auto-GPT. Voici la commande :

sudo apt install git

Vérifiez l’installation de Git à l’aide de cette commande :

git --version

Maintenant, créons et activons un environnement Python pour nous assurer que vous pouvez configurer les modules requis pour Auto-GPT. Pour ce faire, exécutez les commandes suivantes, une à la fois :

mkdir myproject

cd myproject

python3 -m venv myenv

source myenv/bin/activate

2. Obtenir le référentiel Auto-GPT

Vous pouvez récupérer les fichiers et le code Auto-GPT depuis le dépôt en utilisant Git ou manuellement. Nous vous expliquons les deux afin que vous puissiez choisir en fonction de vos préférences.

Cloner le référentiel via Git

Téléchargez Auto-GPT en clonant le contenu du dépôt à l’aide de la commande git :

sudo git clone https://github.com/Significant-Gravitas/AutoGPT.git

Il créera automatiquement le dossier AutoGPT contenant tous les fichiers récupérés dans votre répertoire courant.

Télécharger le référentiel sous forme de fichier ZIP

Si vous souhaitez télécharger les fichiers manuellement, ouvrez le dépôt officiel d’Auto-GPT sur votre navigateur web. Cliquez sur le bouton Code et sélectionnez Télécharger ZIP.

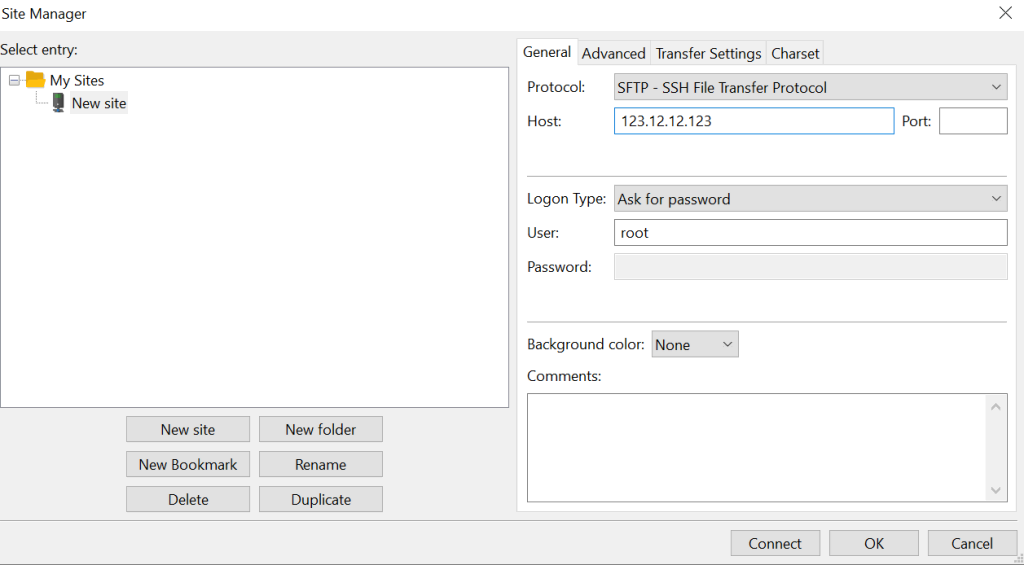

Téléchargez le fichier d’archive depuis votre ordinateur local vers le serveur virtuel distant. Pour plus de simplicité, nous utiliserons le protocole de transfert de fichiers sécurisé (SFTP). Voici les étapes à suivre :

- Téléchargez et installez le client FileZilla.

- Ouvrez l’application, puis allez dans Fichiers → Gestionnaire de sites → Nouveau site.

- Choisissez SFTP comme protocole et entrez toutes les informations requises. Cliquez sur Connecter.

- Localisez le fichier d’archive dans le répertoire de téléchargement de votre ordinateur local. Faites-le glisser et déposez-le dans la fenêtre de droite.

Vous pouvez décompresser le fichier du référentiel sur votre ordinateur local avant de le transférer sur le VPS ou l’extraire à l’aide de la commande Linux unzip sur le serveur distant. Nous recommandons cette dernière solution car le transfert de ZIP est plus efficace.

3. Installer les paquets requis

Les exigences d’Auto-GPT incluent plusieurs paquets Python. Au lieu de les installer individuellement, appelez le fichier requirements.txt pour configurer toutes les dépendances automatiquement :

Avant cela, assurez-vous de changer votre répertoire de travail en /AutoGPT en exécutant cd AutoGPT. Ensuite, entrez ce qui suit pour démarrer l’installation :

pip install -r docs/requirements.txt

Si vous rencontrez des problèmes de permission, exécutez la commande en tant que sudo et ajoutez l’option -user :

sudo pip install --user -r docs/requirements.txt

Important ! Vous pouvez ajouter l’option –break-system-packages si cela ne fonctionne toujours pas. Cependant, soyez conscient que cela peut casser l’installation de pip.

4. Configurer la clé API OpenAI

Utilisez la clé API d’OpenAI pour connecter Auto-GPT au grand modèle de langage (LLM) de GPT. Voici comment procéder :

- Créez un nouveau compte sur la page de connexion de l’OpenAI. Sautez cette étape si vous en avez déjà un.

- Allez sur la page de génération de clés de l’API OpenAI. Cliquez sur Créer une nouvelle clé secrète.

- Saisissez un nom et appuyez sur Créer une clé secrète.

- Copiez la clé secrète et conservez-la dans un endroit sûr, car vous ne pourrez plus la consulter. Cliquez sur Terminé.

Naviguez vers AutoGPT/classic/original_autogpt et suivez ces étapes pour placer la clé API dans le fichier .env d’Auto-GPT :

- Renommez le fichier .env.template pour l’activer :

sudo mv .env.template .env

- Ouvrez le fichier à l’aide d’un éditeur de texte tel que nano :

sudo nano .env

- Supprimez le symbole du dièse (#) et entrez votre clé API dans la variable OPENAI_API_KEY. Elle ressemblera à ceci :

OPENAI_API_KEY=abcdef12345

- Appuyez sur Ctrl + X, Y et Entrée pour enregistrer les modifications.

Vous pouvez également déterminer le modèle LLM pour différentes tâches. Pour ce faire, modifiez les valeurs SMART_LLM et FAST_LLM en GPT 3.5 ou 4 dans le fichier .env.

5. Démarrer Auto-GPT

Pour lancer l’outil IA, accédez à AutoGPT/classic/original_autogpt et entrez cette commande dans votre interface de ligne de commande :

python -m autogpt

Lorsque le message de bienvenue s’affiche, appuyez sur Entrée pour commencer à utiliser l’outil.

6. Configurer Docker (optionnel)

Utilisez Docker pour installer Auto-GPT dans un environnement isolé et portable. C’est un moyen plus fiable d’exécuter l’outil en arrière-plan qu’un multiplexeur comme Screen Linux.

Après avoir installé Docker sur votre système Ubuntu, construisez une image Docker pour votre projet à l’aide de cette commande :

docker build -t autogpt .

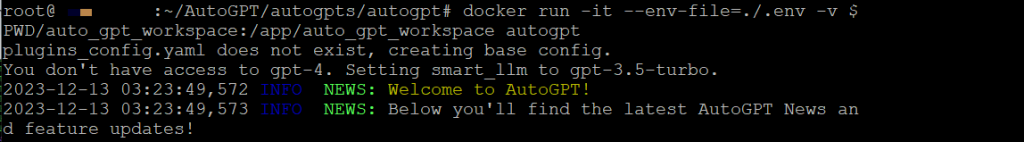

Exécutez le conteneur Auto-GPT à l’aide de la commande ci-dessous :

docker run -it --env-file=./.env -v $PWD/auto_gpt_workspace:/app/auto_gpt_workspace autogpt

Vous pouvez également utiliser ces commandes si vous avez déjà installé Docker Compose :

docker-compose build auto-gpt

docker-compose run --build --rm auto-gpt

Résolution des problèmes d’installation d’Auto-GPT

Dans cette section, nous examinerons plusieurs problèmes courants liés à l’installation de l’Auto-GPT et leurs solutions.

Modules manquants

Si vous ne pouvez pas exécuter Auto-GPT et que Terminal affiche un module manquant, vérifiez si vous vous trouvez dans le bon répertoire. Vous devez exécuter la commande dans le dossier du code source AutoGPT/classic/original_autogpt.

En outre, ce problème peut survenir lorsque vous avez mal configuré les dépendances. Pour résoudre ce problème, réinstallez les paquets requis à l’aide de la commande pip install -r requirements.

Si d’autres modules sont manquants, installez-les à l’aide de Poetry. Après avoir navigué jusqu’au dossier AutoGPT/classic/original_autogpt, exécutez les commandes suivantes :

poetry install

Relancez le module python autogpt et le problème devrait être résolu. Si l’erreur persiste, utilisez pip pour installer manuellement tous les modules manquants. Par exemple, si Terminal indique qu’il manque un modèle de plugin à Auto-GPT, entrez :

pip install auto_gpt_plugin_template

Dans le même temps, si vous rencontrez une erreur de module Git manquant, exécutez cette commande :

pip install gitpython

auto-gpt.json manquant

Le processus d’installation de l’Auto-GPT devrait automatiquement créer un fichier auto-gpt.json. Cependant, s’il n’existe pas, votre interface de ligne de commande renverra une erreur car l’outil ne parvient pas à stocker les données.

La manière la plus simple de résoudre ce problème est de créer le fichier manuellement dans le dossier racine de l’Auto-GPT à l’aide de la commande touch de Linux :

sudo touch auto-gpt.json

Erreurs de connexion à l’API

Une clé API mal configurée peut provoquer des erreurs de type Bad Gateway. Si vous n’avez pas de jetons gratuits, assurez-vous d’avoir configuré une méthode de paiement et des détails de facturation dans OpenAPI. Sinon, Auto-GPT ne peut pas se connecter au LLM GPT, ce qui l’empêche de traiter vos invites.

Si vous rencontrez une erreur de clé invalide malgré une configuration correcte de l’API dans .env, essayez de mettre la clé dans le fichier de configuration de l’Auto-GPT. Pour ce faire, entrez la clé directement dans le fichier config.py dans le chemin Auto-GPT/autogpt/config.

Comment utiliser Auto-GPT

Une fois l’Auto-GPT lancé, décrivez votre tâche et l’outil attribuera un agent IA avec des rôles et des objectifs spécifiques.

Par exemple, si vous demandez à Auto-GPT de “rédiger le contenu d’un article sur l’IA”, il affectera EditorGPT, dont le rôle est d’aider les rédacteurs à créer un contenu de haute qualité. Vous pouvez également saisir diverses prompts IA pour la gestion de VPS afin de générer des instructions pour l’administration du serveur.

Saisissez des données de suivi ou de confirmation en fonction des instructions, qui peuvent varier selon l’agent. Pour les nouveaux utilisateurs d’Auto-GPT, nous recommandons de lire notre tutoriel sur le prompt engineering IA.

Pour des tâches spécifiques, vous pouvez ajouter les options suivantes à la commande python pour exécuter Auto-GPT :

- –speak. L’agent fournira une sortie audio en utilisant la synthèse vocale.

- –continous. Auto-GPT exécute la tâche de manière autonome sans l’autorisation de l’utilisateur.

- –self-feedback. L’outil fournira automatiquement un feedback en vérifiant ses actions en fonction de la tâche.

Avertissement ! Auto-GPT ne recommande pas l'utilisation des options --continuous et --self-feedback car elles peuvent conduire à des comportements inattendus.

En outre, vous devez configurer des clés API supplémentaires pour des tâches autres que la génération de texte. Par exemple, intégrez Dall-E pour créer des images et ElevenLabs pour la fonctionnalité de synthèse vocale.

Bonnes pratiques d’Auto-GPT

Dans cette section, nous expliquerons les meilleures pratiques d’Auto-GPT pour vous aider à comprendre comment utiliser efficacement la technologie de l’IA dans le développement de votre site web ou de votre application.

Configurer Auto-GPT pour des tâches spécifiques

La personnalisation des paramètres Auto-GPT vous permet de configurer l’outil spécifiquement pour votre tâche. Vous pouvez le faire en déterminant le rôle, le nom et l’objectif de l’agent dans un fichier YAML.

Ce fichier vous permet d’exécuter l’outil d’IA de manière cohérente pour des tâches spécifiques sans avoir à spécifier à plusieurs reprises les rôles et les objectifs. Par exemple, nous allons créer une configuration d’agent d’écriture :

nano writer_ai_settings.yaml

Saisissez le nom, le rôle et l’objectif de l’IA. Ceux-ci varient en fonction de vos tâches. Voici un exemple :

ai_name: WriterGPT

ai_role: Un assistant IA conçu pour effectuer des recherches et rédiger un article attrayant afin d'attirer les lecteurs.

ai_goals:

- Effectuer des recherches sur le contenu de l'article pour s'assurer de sa validité.

- Créer une structure d'article.

- Rédiger un contenu écrit attrayant pour un site web afin d'attirer les lecteurs.

Pour appliquer les configurations, appelez le fichier à l’aide de l’option –ai-settings lors de l’exécution d’Auto-GPT :

python -m autogpt --ai-settings writer_ai_settings.yaml

Pour définir le fichier par défaut, saisissez son nom dans la variable AI_SETTINGS_FILE du fichier .env. Vous pouvez également définir des configurations de prompt en créant un fichier similaire et en l’appelant dans votre commande à l’aide de l’option –prompt-setting.

Utiliser des scripts personnalisés pour améliorer les fonctionnalités

Étendre les fonctionnalités et les sources de données de l’Auto-GPT à l’aide de scripts personnalisés appelés plugins. Par exemple, vous pouvez installer le plugin Wikipedia pour permettre à l’outil d’extraire des données du site web.

Il est possible de créer le vôtre en utilisant le modèle _init_.py ou d’installer des plugins préconfigurés à partir de leurs dépôts. Comme les étapes de configuration diffèrent légèrement en fonction du plugin, assurez-vous de consulter le manuel d’instructions.

En règle générale, vous devez extraire les fichiers dans le dossier plugins de l’Auto-GPT et ajouter le plugin au fichier .env.

Optimiser l’utilisation de la mémoire pour traiter de grands ensembles de données

Les utilisateurs peuvent mettre en cache l’historique des interactions Auto-GPT afin d’optimiser le traitement des données et de permettre la création d’invites adaptatives en fonction du contexte. Pour les systèmes peu performants, cela permet à l’outil d’IA de fonctionner de manière optimale lors de l’exécution de tâches complexes.

Une façon courante de le faire est de configurer la base de données vectorielle Pinecone à l’aide de l’API. Vous pouvez également utiliser Redis, qui est inclus dans Auto-GPT si vous installez l’outil à l’aide de Docker Compose.

Pour le mettre en place, exécutez cette commande pour créer un conteneur Redis :

docker run -d --name redis-stack-server -p 6379:6379 redis/redis-stack-server:latest

Entrez les paramètres suivants dans le fichier .env. Remplacez le mot de passe par le vôtre :

MEMORY_BACKEND=redis MEMORY_BACKEND=redis REDIS_HOST=localhost REDIS_PORT=6379 REDIS_PASSWORD="Mot de Passe"

Intégrer Auto-GPT avec d’autres API

L’intégration de l’Auto-GPT avec d’autres plateformes vous permet d’étendre les fonctionnalités de l’outil. Par exemple, vous pouvez activer la génération d’images dans l’outil IA en utilisant Dall-E ou Stable Diffusion.

En attendant, utilisez ElevenLabs ou l’API Microsoft Azure Text-to-speech pour activer la sortie vocale. Pour la transcription automatique de la parole, utilisez Hugging Face.

Si vous souhaitez simplifier le développement d’applications d’IA, intégrez Auto-GPT avec LangChain. Pour utiliser ces outils, récupérez leurs clés API sur les sites web respectifs et placez-les dans le fichier .env.

Conclusion

Auto-GPT est un agent d’intelligence artificielle polyvalent et autonome pour diverses tâches telles que le développement d’applications et l’analyse de données.

Dans ce guide d’installation d’Auto-GPT, nous avons expliqué les étapes pour configurer l’outil dans un environnement VPS :

- Installez Python et Git. Téléchargez la dernière version de Python et de Git en utilisant la commande du gestionnaire de paquets de votre système d’exploitation, comme apt ou yum.

- Télécharger le dépôt Auto-GPT. Dupliquez le dépôt officiel Auto-GPT en utilisant la commande git clone ou en téléchargeant le fichier ZIP via SFTP.

- Installer les dépendances. Exécutez la commande pip install pour télécharger et installer les paquets répertoriés dans le fichier requirements.txt.

- Configurer l’API OpenAI. Créez un nouveau compte OpenAI et générez une clé API. Renommez le fichier .env.template et saisissez votre clé secrète à l’aide d’un éditeur de texte.

- Lancer Auto-GPT. Entrez la commande python -m autogpt pour lancer Auto-GPT.

- Configurer Docker. Installez Docker, créez une image Docker et exécutez le conteneur de service Auto-GPT.

Si vous rencontrez une erreur, assurez-vous que vous disposez du fichier auto-gpt.json et de toutes les dépendances. Vérifiez également que la commande python s’exécute dans le dossier racine de l’Auto-GPT.

Pour utiliser l’outil efficacement, stockez la configuration de l’agent dans un fichier YAML, intégrez d’autres outils avec des clés API et installez des plugins en fonction de vos tâches. Configurez également Pinecone ou Redis pour optimiser les performances d’Auto-GPT.

Comment installer Auto-GPT – FAQ

Pouvez-vous utiliser Auto-GPT gratuitement ?

Alors qu’Auto-GPT est gratuit et open-source, OpenAPI vous facture chaque appel API et chaque mot saisi. Par exemple, l’entrée GPT 3.5 Turbo coûte 0,0010 $ pour 1 000 tokens ou environ 750 mots. Pour plus d’informations, consultez la page de tarification d’OpenAI.

Quelles sont les limites de l’Auto-GPT ?

Auto-GPT ne peut pas convertir une série d’actions en fonctions réutilisables. Il en résulte un manque d’efficacité lorsque l’utilisateur souhaite reprendre sa tâche depuis le début.

Il hérite également des limitations du GPT LLM. Par exemple, le GPT 3.5 a tendance à produire des informations erronées et ne peut collecter des informations que jusqu’en janvier 2022.

Quelles sont les tendances futures pour Auto-GPT ?

L’intégration de l’API Auto-GPT et les capacités d’apprentissage rendent l’outil polyvalent, vous permettant d’automatiser les tâches du début à la fin.

À l’avenir, elle pourrait développer une autre application d’IA avec le cadre LangChain. Elle pourrait également aider les utilisateurs à répondre aux appels d’assistance en direct en leur fournissant des solutions sous forme de synthèse vocale.